作为SEO我们会经常分析网站日志,通过网站日志的分析,我们可以更加了解蜘蛛对网站抓取情况,所谓的网站日志就是记录web服务器接收处理请求以及运行时错误等各种原始信息的以·log结尾的文件,网站日志最大的意义是记录网站运营中比如空间的运营情况,被访问请求的记录。通过网站日志可以清楚的得知用户在什么IP、什么时间、用什么操作系统、什么浏览器、什么分辨率显示器的情况下访问了你网站的哪个页面,是否访问成功。

一、网站日志的作用

1、通过网站日志可以了解蜘蛛对网站的基本爬取情况,可以知道蜘蛛的爬取轨迹和爬取量,通过我们的网站日志,外链的多和少和网站蜘蛛的爬取量是有直接影响的,我们所说的链接诱饵就是如果你做了一个外链,蜘蛛在爬取这个外链页面并把页面放出来时,蜘蛛可以通过你留的这个链接来爬取你的网站,而网站日志正是会记录下蜘蛛的这次爬取行动。

2、网站的更新频率也和网站日志中蜘蛛抓取的频率有关,一般来说更新频率越高,蜘蛛的抓取频率越高,而我们网站的更新不仅仅只是新内容的添加同时还有我们的微调操作。

3、我们可以根据网站日志的反应情况,对我们的空间的某些事情和问题提前进行预警,因为服务器如果出问题的话在网站日志中会第一时间反映出来,要知道服务器的稳定速度和打开速度两者都会直接影响我们的网站。

4、通过网站日志我们可以知道网站的那些页面是很受蜘蛛欢迎的,而哪些页面是蜘蛛连碰都不去碰的,同时我们还能发现有一些蜘蛛由于是过度爬取对我们的服务器资源损耗是很大的,我们要进行屏蔽工作。

二、如何下载日志

在购买空间的时候需要问清楚是否支持网站日志下载,但现在基本虚拟主机都有这功能,网站日志是每天生成一次,我们只需要用FTP工具传到本地就可以。

三、分析网站日志

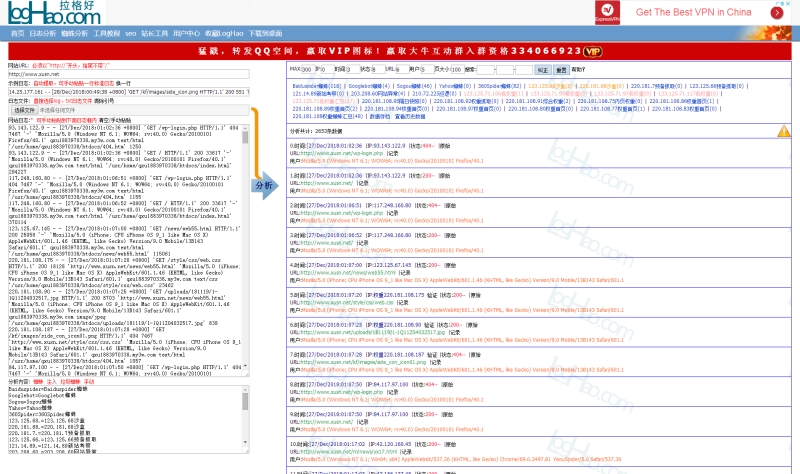

LOGHAO日志分析

LOGHAO日志分析

1、日志的后缀名是log的我们用记事本打开,选择格式里的自动换行这样看起来方便,同时用搜索功能搜索BaiduSpider和Googlebot这两个蜘蛛。

例如:

百度蜘蛛 2012-03-13 00:47:10 W3SVC177 116.255.169.37 GET / – 80 – 220.181.51.144 Baiduspider-favo+(+ baidu /search/spider ) 200 0 0 15256 197 265

谷歌机器人 2012-03-13 08:18:48 W3SVC177 116.255.169.37 GET /robots.txt – 80 – 222.186.24.26 Googlebot/2.1+(+ google /bot ) 200 0 0 985 200 31

我们分段来解释

2012-03-13 00:47:10 蜘蛛爬取的日期和时间点;W3SVC177 这个是机器码这个是惟一的 我们不去管它;116.255.169.37 这个IP地址是服务器的IP地址;GET 代表事件,GET后面就是蜘蛛爬取的网站页面,斜杠就代表首页,80 是端口的意思,220.181.51.144 这个IP则是蜘蛛的IP,这里海瑶SEO快排发包技术小编告诉大家一个鉴别真假百度蜘蛛的方法,我们电脑点击开始运行输入cmd打开命令提示符,输入nslookup空格加蜘蛛IP点击回车,一般真百度蜘蛛都有自己的服务器IP而假蜘蛛则没有。

如果网站中出现了大量的假蜘蛛则说明有人冒充百度蜘蛛来采集你的内容,你就需要注意了,如果太猖獗那会很占用你的服务器资源,我们需要屏蔽他们的IP.

200 0 0这里是状态码 状态码的意思可以在百度里搜索下;197 265最后两个数字则代表着访问和下载的数据字节数。

2、我们分析的时候先看看状态码 200代表下载成功,304代表页面未修改,500代表服务器超时,这些是一般的其他代码可以百度一下,对于不同的问题我们要处理。

3、我们要看蜘蛛经常爬取哪些页面,我们要记录下来,分析他们为什么会经常被蜘蛛爬取,从而分析出蜘蛛所喜欢内容。

4、有时候我们的路径不统一出现带斜杠和不带斜杠的问题,蜘蛛会自动识别为301跳转到带斜杠的页面,这里我们就发现了搜索引擎是可以判断我们的目录的,所以我们要对我们的目录进行统一。

5、我们分析日志分析时间长了,我们能够看出蜘蛛的抓取规律,同一目录下面的单个文件的抓取频率间隔和不同目录的抓取频率间隔都可以看出来,这些抓取频率间隔时间是蜘蛛根据网站权重和网站更新频率来自动确定的。

6、蜘蛛对于我们的页面的抓取是分等级的,是根据权重依次递减的,一般顺序为首页、目录页、内页。

7、不同IP的蜘蛛他们的抓取频率也是不相同的

四、查看网站日志的意义

1、查看访问网站的用户IP、访问页面、停留时间、访问日期等等

2、查看搜索引擎蜘蛛都访问网站那些页面,返回码是什么

3、找出404页面,找出出问题的其他页面,包括死连链接

4、发觉百度蜘蛛每天固定时间来访问网站,那么就可以在固定时间更新网站。

5、访问的页面,有参数(代表动态页面,或者中文URL),三个以上参数的路径不利于优化,那么就有必要写进robots.txt。

6、返回码是不正常的,就有必要处理,让页面恢复正常访问,不能恢复正常访问的死链接,建立txt文档,向百度站长平台提交。

7、404页面可以被百度收录,那么就尽量去恢复网站访问

五、网站日志的分析工具

爱站日志分析工具

这里给大家介绍一款非常好用的网站日志分析工具,就是拉格好分析工具http://www.loghao.com/,可以选择导入日志后进行分析,或者使用爱站等各类SEO工具,都可以直接分析网站日志。